Anaconda, Python ve R dilleri için veri bilimi ve makine öğrenmesiyle ilgili kütüphanelerin yönetimini ve kurulumunu kolaylaştıran ücretsiz bir dağıtımdır. Windows, Linux, ve MacOS’la uyumlu çalışan ve 6 milyondan fazla kullanıcısı olan Anaconda 250'den fazla popüler veri bilimi ve makine öğrenmesi kütüphanesine sahiptir. [1]

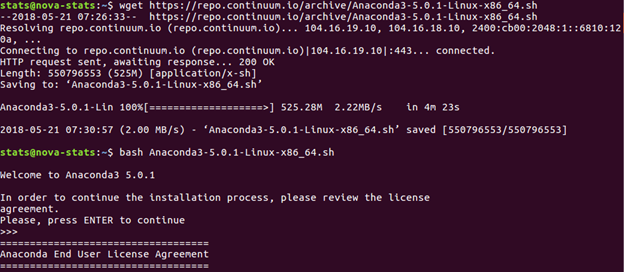

Kurulumu gayet basit repodan güncel Anaconda versiyonunu çekiyoruz ve çalıştırıyoruz.

wget https://repo.continuum.io/archive/Anaconda3-5.0.1-Linux-x86_64.sh

bash Anaconda3-5.0.1-Linux-x86_64.sh

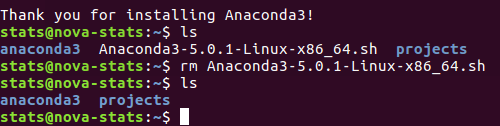

Anaconda’yı kurduk artık .sh uzantılı dosyayı silebiliriz.

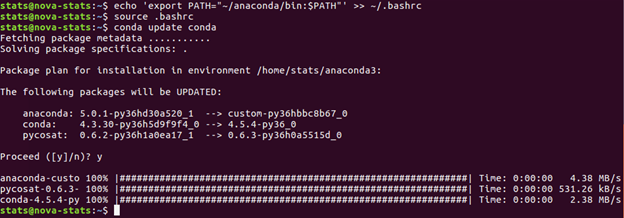

Oturum açarken otomatik olarak çalışmasını istediğimiz komutların bulunduğu ~/.bashrc dosyasına Anaconda’yı PATH’e eklemesini söyleyip update edelim şimdi de.

echo 'export PATH="~/anaconda/bin:$PATH"' >> ~/.bashrc

source .bashrc conda update conda

İşlem tamam makine öğrenmesi paketlerine ek olarak jupyter notebook da hazır olarak yüklenmiş oldu. Terminalden jupyter notebook yazarak web konsoluna bağlanabilirsiniz.

jupyter notebook

Spark ve PySpark

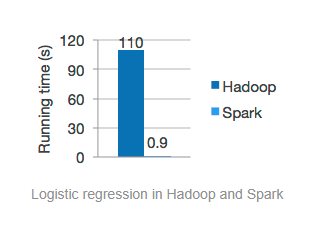

Spark, büyük ölçekli verileri hızlı bir şekilde işlemeye yarayan Scala ile geliştirilmiş açık kaynak kodlu cluster-computing teknolojisidir. Hızının MapReduce modelinden 100 kattan fazla olduğu iddia ediliyor.

Spark Mlib kütüphanesi sayesinde makine öğrenmesi, Spark Streaming sayesinde gerçek zamanlı veri analizi uygulamaları geliştirebilir, Spark SQL sayesinde de büyük veriler üzerinde sorgular yapabilirsiniz.

PySpark Python’da Spark uygulamaları geliştirmek için yazılmış bir API. R dili için de SparkR API mevcut. PySpark kurulumuna geçelim şimdi de.

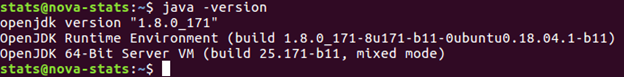

Adım 1: Java

Eğer bilgisayarınızda Java yüklüyse bu adımı atlayabilirsiniz değilse aşağıdaki komutla yükleme işlemini tamamlayabilirsiniz.

sudo apt install openjdk-8-jre-headless

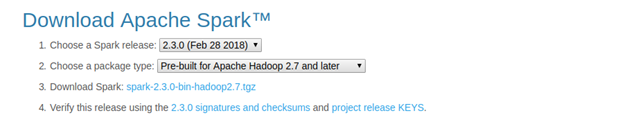

Adım 2: Spark

https://spark.apache.org/downloads.html

Yukarıdaki linkten Spark’ı lokalinize indirebilirsiniz.

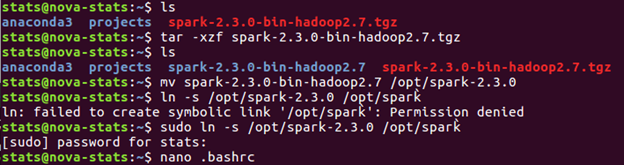

Adım 3: Kurulum ve Konfigürasyonlar

Sonraki adımda dosyayı unzip yaparak /opt klasörüne yerleştiriyoruz ve sembolik bir link oluşturuyoruz.

tar -xzf spark-2-3.0-bin-hadoop.2.7.tgz mv spark-2.3.0-bin-hadoop2.7 /opt/spark-2.3.0 sudo ln -s /opt/spark-2.3.0 /opt/spark

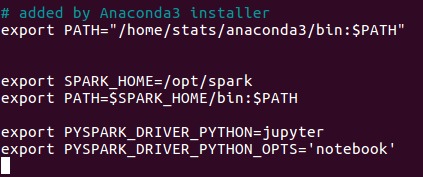

Son olarak .bashrc dosyasını açıp ona Spark’ın yerini gösteriyoruz ve PySpark Driver’ına jupyter notebook tanımlıyoruz.

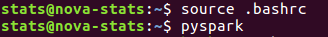

Değişiklikleri etkinleştirdikten sonra konsola pyspark yazdığında jupyter notebookta Spark uygulamalarınızı geliştirmeye başlayabilirsiniz.

Next next next yaparak kurulum yapamadığımız bir dünyada kurulumlar oldukça sancılı süreçler haline gelebiliyor. Hem Anaconda hem de Spark kurulumunda sorun yaşadığınız bir yer olursa mutlaka yazın.

Gündelik hayattan örnekler bularak kavramları basitleştirerek ve paylaşarak öğrenmenin gücüne inanan biri olarak sorularınız, önerileriniz ve eleştirileriniz çok değerli.

Çalışmanın Medium versiyonuna şuradan ulaşabilirsiniz.

Sorunuz olursa bana Linkedin veya Twitter hesaplarından yazabilirsiniz.